Nova IA transforma voz em vídeo a partir de fotos

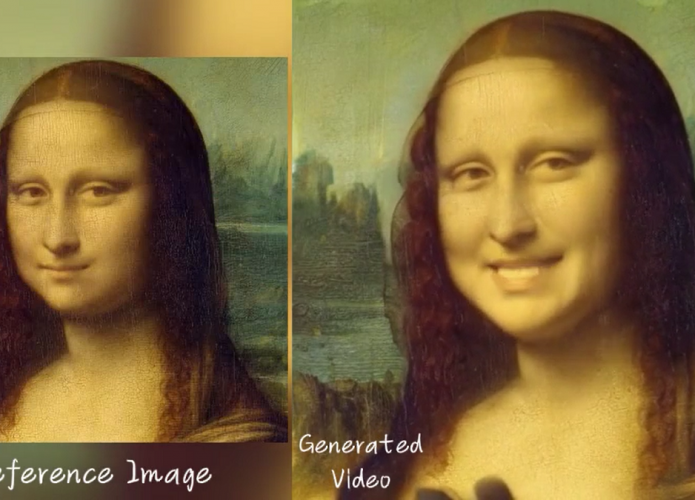

Pesquisadores do Instituto para Computação Inteligente do Alibaba Group desenvolveram um novo sistema de inteligência artificial (IA) capaz de transformar fotos do rosto de uma pessoa em vídeos animados, como se ela estivesse falando ou cantando. A tecnologia, chamada Emote Portrait Alive (EMO), combina a imagem estática com áudios de pessoas falando ou cantando.

Diferente de outros sistemas que já transformavam fotos em animações semi-animadas, a equipe do Alibaba adicionou som aos vídeos gerados pelo EMO. Além disso, eles conseguiram realizar esse processo sem utilizar modelos 3D ou referências faciais. Em vez disso, os pesquisadores utilizaram modelagem de difusão baseada no treinamento de IA em grandes conjuntos de dados de arquivos de áudio e vídeo, totalizando cerca de 250 horas de dados.

Para criar os vídeos animados, o sistema converte automaticamente as ondas de áudio em quadros de vídeo, capturando gestos humanos sutis, peculiaridades de discurso e outras características que identificam uma imagem animada de um rosto como sendo humano. Os vídeos gerados podem recriar os movimentos da boca e as expressões tipicamente associadas a palavras e frases.

Segundo os pesquisadores, o EMO supera outras aplicações em termos de realismo e expressividade. No GitHub da equipe, é possível encontrar vários outros vídeos demonstrando o sucesso da ferramenta. No entanto, eles ressaltam que o uso do EMO precisará ser restrito ou monitorado para evitar seu uso antiético.

Os resultados e detalhes do desenvolvimento da ferramenta foram publicados no servidor de pré-impressão arXiv.

Reescreva a notícia original para evitar plágio:

Nova IA transforma voz em vídeo a partir de fotos

Pesquisadores do Instituto para Computação Inteligente, do Alibaba Group, apresentaram um novo sistema de inteligência artificial (IA) capaz de transformar fotos do rosto de uma pessoa em vídeos animados. Chamada de Emote Portrait Alive (EMO), a tecnologia combina a imagem estática com áudios de pessoas falando ou cantando. Diferentemente de outros sistemas semelhantes, o EMO adiciona som aos vídeos gerados e não utiliza modelos 3D ou referências faciais.

A equipe do Alibaba utilizou a modelagem de difusão durante o treinamento da IA, utilizando grandes conjuntos de dados de arquivos de áudio e vídeo, totalizando cerca de 250 horas de dados. O sistema é capaz de converter automaticamente as ondas de áudio em quadros de vídeo, capturando os gestos e as características que identificam uma imagem animada de um rosto como sendo humano. Os vídeos gerados pelo EMO recriam os movimentos da boca e as expressões associadas a palavras e frases.

De acordo com os pesquisadores, o EMO se destaca por sua capacidade de gerar vídeos realistas e expressivos. Além disso, a ferramenta foi considerada superior a outras aplicações do mercado. No GitHub da equipe, é possível encontrar vários vídeos que demonstram o sucesso do EMO. No entanto, os pesquisadores alertam que seu uso deve ser restrito ou monitorado para evitar possíveis abusos éticos.

Os resultados e detalhes do desenvolvimento da ferramenta foram publicados no servidor de pré-impressão arXiv.